最近,“AI作画”产出的作品似乎成了一股互联网风潮。这些初看惊艳、气氛拉满,仔细琢磨又看不出所以然的画作往往给人留下深刻印象。当人们得知这些画作完全由AI绘制,更是又多了一份惊异与危机感。

一些AI作画的成品效果的确十分惊艳

(资料图片仅供参考)

(资料图片仅供参考)

虽然涉及复杂的机器学习算法,AI作画的原理解释起来并不复杂。用户可以在平台上输入各种与风格、主题、氛围有关的关键词,AI根据这些关键词在互联网浩如烟海的资源和素材中搜索、学习,最后糅合与拼接成一些符合要求的画作。

拿在移动端十分红火的Wombo Dream为例,它是一个面向大众用户的AI作画工具,界面可视化程度高,操作简单。我在界面中选择“吉卜力风格”,输入主题“梦中梦”,并且上传了一张湖中小船的图片作为参考基准。很快,AI就给我生成了一张和吉卜力动画背景类似的成品。

移动端面向大众的Wombo Dream操作简单,生成图片的速度很快

除此之外,还有很多更专业、侧重点不同的图像制作AI。比如谷歌的Disco Diffusion可调参数更多,能够详尽地设置图片的大小、质量,在描述上的要求也更加精细,可以涵盖画师风格、色调、主题等许多方面。这使得它生成的一些图片仿佛出自真人画师之手。而Midjourney模仿了各种用户可能对真人画师提出的需求,是不少从事数字绘画的艺术家的宠儿。Stable Diffusion是一款开源软件,许多游戏开发者都青睐于它广阔的应用前景。Artbreeder则因为对真人头像的模拟,早几年就在网络上风靡。

虽然这项技术并不是近年才有,但随着AI技术的发展和互联网带来的更多素材,这一类产出作品的质量肉眼可见地日益提升,效率也大大升高。今年年初,先不论画得怎么样,一些AI画图工具画一张图还要1小时左右,现在这个时间已经缩短到十几秒了。

如果说普通用户使用这类AI作画是为了满足自己内心对种种场景的幻想,游戏开发者们则从中看到了更多潜力。

触乐找到几位开发者,他们或多或少地正在自己的游戏中进行探索和实验,寻找应用这项技术的可能。

从机械化的劳动中解放

“正义的史官”(化名)是一款策略游戏的开发者。联系上他时,他开玩笑说,自己正在朋友圈里“布道”,号召同行们都来尝试AI作画。他自己已经开始在项目中使用,而且感觉用得很顺手。说到AI画图的好处,他提得最多的是“量大”“速度快”,尤其在开发初期找概念方向的时候,效率比人工画图高出非常多。

在这个阶段,策划最想看的是画面的整体效果和大感觉,但很多具体细节还无法确定。打个比方,假如他们想做一个黑暗奇幻背景的游戏,可能有哥特风、中世纪风、工业风等等好几个方向。在无法判断哪些元素组合和色彩搭配效果最好的情况下,反复提需求可能会造成人力的无谓消耗。“AI作画就不一样,我们可以不断调整关键词,调一次让AI出100张看看效果。”史官说,“如果我让公司美术或者外包先出100张看看效果,他们应该会直接把我从窗口扔下去……”

在角色设计上也是一样。“假如我想设计个外星人形象,可以先让AI来500个看效果,再从中挑一个进行更细致的设计。”他继续说,“你不可能让真人画师去承担这种试错成本,但AI就无怨无悔。”

已经有艺术家尝试用AI生成图片,参加数字艺术比赛,这是获奖作品

除了提供灵感大方向,AI生成的图片还可以当作参考素材。邢峰(化名)是一款主打文字叙事和换装类游戏的制作人。他的游戏中有大量涉及服装褶皱、布料质感和飘逸动态的绘画。

“这种东西你不可能让画师凭空去想,他们平时画也要找很多参考,而且找到角度和姿势合适的参考其实很麻烦,”邢峰介绍说,“输入关键字,直接拿AI出的图当参考就方便很多,而且也不用考虑潜在的动态、姿势之类的侵权问题,因为AI是凭空给你做出来的。更何况,AI做的3D渲染,一般打光都比较正确,不需要你再自己去脑补。”

不过AI生成的概念图、人物图目前很难直接使用。“最后还是得让画师来画,毕竟AI生成的东西都很破碎,它没有一个统一的设计,直接拿来用,不太符合我们的项目需求。”邢峰说。

目前最接近于直接可用的AI作画的成品,主要集中在一些相对简单的平面图案设计和3D素材贴图上。这类图片一旦生成,开发者只需要进行一些裁切、调色之类的简单处理,就能应用到游戏中。

我尝试用AI生成了一幅写实风景,这种效果作为一些文字类游戏不太重要的背景,已经接近于直接可用

简单的平面图案设计包括各种旗帜图标、徽章、法阵等等。如果它们与游戏的世界观、情节并不紧密挂钩,不需要专门设计,就可以交给AI去批量产出。

史官开发的游戏中就要用到很多勋章图案和供玩家选择的旗帜图标。这种美术素材在游戏中不占据重要地位,如果让画师人工设计和绘制,一个人一天最多只能画出十几个,投入和产出非常不平衡。“用AI画,如果画勋章,一晚上能出大几千个,图标一天能出1万个。拿到成品之后再用脚本切图打包,比人力不知道快多少倍。”他如此形容效率的巨大差距。

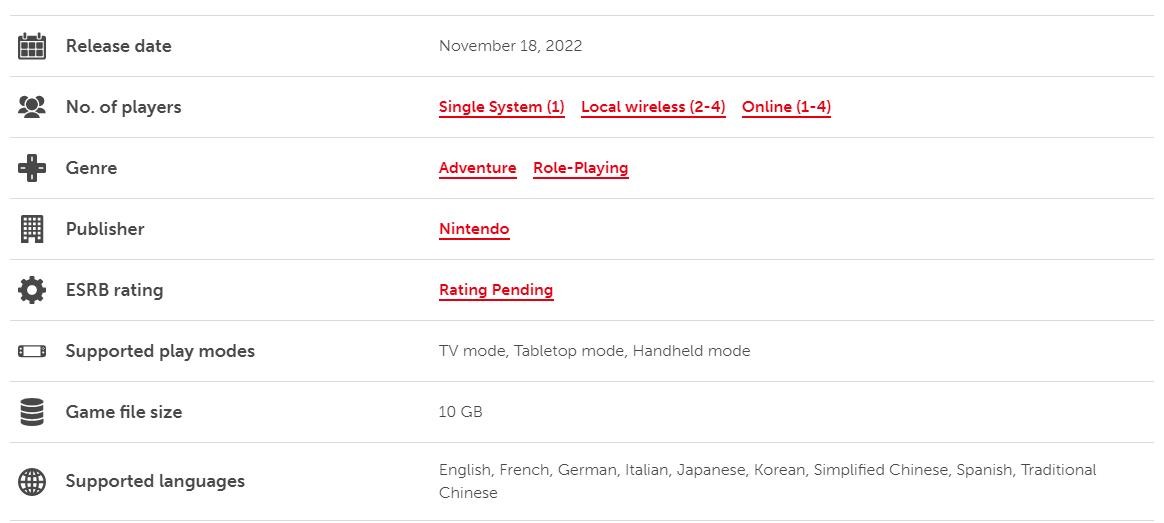

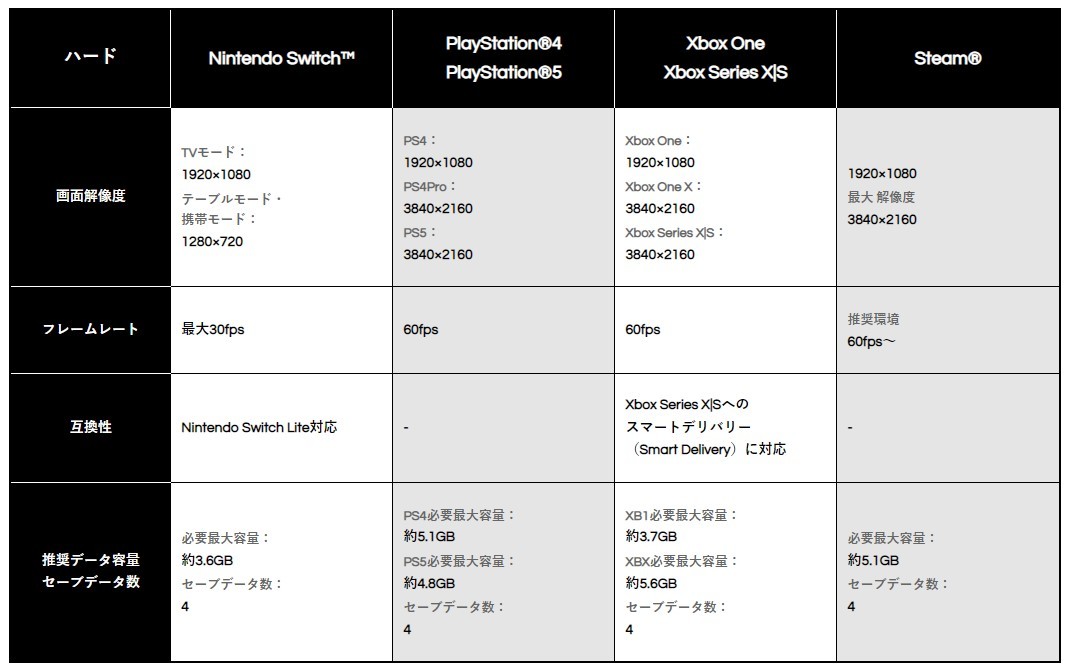

他进一步计算了不同设备下AI的出图效率:“我们现在主要租用的是谷歌云。AI画图工具Stable Diffusion出的图,以一张图512×512像素为标准,在Stable Diffusion里走50步的话,用T4显卡大概需要15秒,64步大概20秒,步数越多时间越长。要是有V100的显卡,估计50步几秒就出来了。出图数量可以自己设置。电脑的显存决定能不能生成足够大的图,GPU决定有多快。”

至于开销,Stable Diffusion本身是免费的开源软件,谷歌云的花费则是每月10美元,更高的配置也仅需50美元。

邢峰也提到了一些接近于一次性使用、在游戏中不起到重要作用的图案。“假如要做一个兽人小兵,出来不到一分钟就被打回去的那种,他身上的文身就完全可以用AI生成。还有各种魔法阵,设计起来其实很麻烦,在游戏里作用却不大,直接找素材又很容易碰到版权纠纷……”AI作画可以把画师从这类机械化的劳动中解放出来。

但并不是所有平面纹样都适用于AI,最终要看的还是开发者的需求。“比如衣服上的刺绣、布料上的花纹,这些在我们的游戏里涉及到世界观、文化、阵营等等,还挺重要的。”邢峰说,“所以这些我们还是人工设计,不会用AI来画。”

开发者们觉得用起来最没有负担的是AI生成的3D贴图素材,尤其是石头花纹、花草树木这类放之四海而皆准的东西。如果他们需要的只是写实背景,这些逼真、没有特殊风格,也不存在版权的自然外观,可以算作最方便的素材,甚至生成之后也不需要多少人工修正。

独立开发者叶兰舟也一直关注着AI作画,他进一步解释了目前厂商使用AI作画工具的关键:“AI现在是一个混沌的黑箱。在图出来之前,你很难知道自己会得到什么结果,每一个关键字会在里面起到什么作用,也是不清楚的。”

现在开发者们对AI作画的调试,更像是在完成“关键词猎手”的工作。“其实核心就是两点:找到自己游戏风格对应的关键词组,以及筛选适合在游戏里发挥的图。”

他拿出一张很接近游戏原画的白发女性人像作为例子。要生成这张图,除了基本的“girl with super long hair, hair becoming white snow”(超级长发女孩,头发雪白)的关键词之外,还要加上各种其他的限制。比如“细节丰富”“数字绘画”“Artstation”“概念设计”“光滑”“聚焦清晰”“虚幻引擎5”“8K”等。最后,还要加入“by Artgerm and Greg Rutkowski and Alphonse Mucha”等著名画家的名字对图画的风格进行调整。

开发者要调整多次关键词才能生成自己想要的效果

“所以,关键词就跟咒语一样,需要不断地尝试调换,看怎么样才能出来最能表达自己想法的风格。”叶兰舟说。一般来说,根据成图的复杂程度,调整关键词的过程在15分钟至1小时之间。

无法代替人类,也确实存在问题

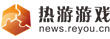

目前,AI作画技术仍然处在不断的变化发展之中,可以用“日新月异”来形容。哪怕把今年年初的AI作画和现在相比,效果也是天差地别。

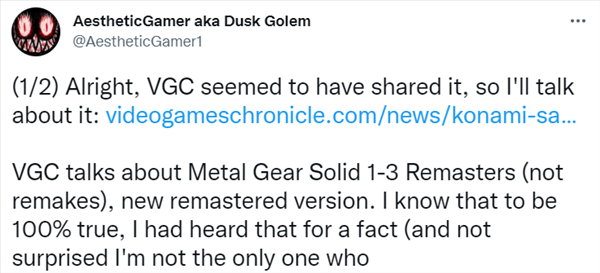

叶兰舟回忆了几个印象深刻的例子。大约在今年三四月,使用DDV5这一AI作画工具,以“德鲁伊”“Pablo Amaringo”“Artstation流行”等关键词绘制的图画在氛围和画面元素上已经足够令人印象深刻,但当时还基本上无法生成正常的人脸。几个月后,DALL-E2已经可以生成比较准确的五官,而Stable Diffusion在画面表现上更上一层楼。

大约5个月前,DDV5生成的德鲁伊主题图片效果

经过几个月的发展,DALL-E2(左)和Stable Diffusion(右)的图片生成质量都大有提升

另一个例子是Midjourney在两个月的时间内,以同样的关键词生成的以鱼为主题的图片。

“所以AI进化的速度真的非常惊人,简直像超人剧变,每天甚至每小时都在变化。”叶兰舟如此评价。

时隔两个月,Midjourney对同组关键词生成的不同画面

与所有引起人们注意的新兴事物一样,AI作画在引人惊叹的同时也带来了不少争议。

首先是一种久已有之的担忧:AI的发展,乃至广义上机器学习的发展是否最终会代替人工?这个问题有些形而上,讨论起来还挺复杂的。但从开发者们最务实的角度来看,答案其实比较简单:目前来说,“远远没到可代替的程度”。

就像前文所说,AI依然只是工具,只能对美术方面的重复性劳动进行辅助,是用来解放画师而不是代替画师的。“或者说,它们代替的是缺乏创造性的劳动。”邢峰说,“对AI生成的素材进行筛选,以及最终的设计和绘画,还是得让真人来,只不过简化了前面若干会让真人画师‘头秃’的步骤。”

史官说,根据他在同行圈子里“卖安利”的经验,策划和制作人尝试AI作画的积极性最高,画师的积极性最低,但不是因为画师觉得自己会被替代。“他们对AI作画本身没有兴趣,最关心的是用AI辅助进行绘画的实例。”

另外,哪怕AI能画出各种精致的图片,在实际应用上,开发者们依旧处在探索和研究的阶段,离真正的工业化、大规模应用还有一段距离。

首先,工业化的开发者工具往往需要和其他常用工具的接口,方便创作者在不同软件之间随时拷贝和编辑素材,而目前大部分AI作画工具都缺乏这项功能。许多人已经注意到了这个问题,并正在努力解决。“比如我们使用的Stable Diffusion现在已经开源了,以后应该会有更多优化和工具的接入。现在已经有接入Photoshop的视频了。”史官说。

史官提到的这段演示视频的效果确实让人惊讶。将Stable Diffusion接入Photoshop后,画师几乎能够随时通过输入关键词的方式,用AI生成的内容填补画布上的空白,然后直接用画笔在上面修改,俨然多了一个有求必应的绘图助理。

画面上的建筑和植物都是先用AI生成,再手动绘制调整出来的

邢峰则希望有更多让开发者定制的内容,比如定制素材库。“假如我们原来做了一个特别风格化的游戏,接下来想做个类似的,能不能把我们自己的素材上传上去训练AI,让AI给我们画呢?”

叶兰舟将这个过程称为针对某个画师或者特定画风的小规模机器训练,但目前大部分渴望用上的游戏厂商还没有能力进行。“不过大家已经在做研究了,比如现在Stable Diffusion的开发者说,训练包最终会压缩到100MB……这样我们大概就能拿来跑训练了。” 这个趋势的发展速度也很快。这两天史官下载的版本,训练包已经从7GB变成了2.7GB。

在形而上的“AI是否会取代人类”的讨论之外,AI作画确实存在一些灰色地带没有解决。这些问题给它商业化、工业化的应用前景蒙上了一层阴影。

通常情况下,开发者们不太担心AI生成的纹样、姿势等出现版权问题。“因为AI生成的东西是‘长’出来的,就像一棵树不会长出两片相同的叶子,哪怕用同一组关键词,AI也会给不同的人画出不同的东西。”邢峰说。

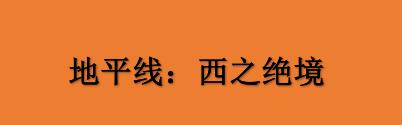

但有些版权概念更为模糊,比如画风。这是目前AI作画争议的焦点。因为训练AI时的不少关键词都涉及到画师的风格,使用者既可以指名道姓地输入现有著名画师的姓名,也可以输入诸如“吉卜力”“迪士尼”这样已经相对稳定的商业流派。结果,当AI作画的成品和这些参考图的风格越来越像,画师们难免会感到被冒犯。

8月底,已经有不少日本画师在社交平台声明,禁止AI学习自己的画风。抗议涉及的AI作画平台Mimic主打二次元头像,他们放出的对比图乍一看的确难辨真假。

用户上传画师们已有的作品,Mimic用AI生成新的画风类似的头像

尽管叶兰舟从开发者的角度指出,如果真的要应用在游戏中,AI生成的角色在面部表情、形象的连续性(指角色长相在不同场景中不会“一人千面”)等方面仍有不少瑕疵,但光从静态图看,AI过强的模仿能力似乎一下子就让画师们十几年的努力显得岌岌可危。

因为争议过大,Mimic现在已经宣布终止测试,并声称将在正式版中加入保护画师版权的措施。

一些欧美游戏厂商的概念设计师也站出来指责这类AI工具是“版权洗衣机”,认为它们对画风的模仿空洞且华而不实。也有设计师认为,可能行业大佬确实不会被AI取代,但初出茅庐的新手画师就不一定了。

此外,AI作画中出现的人像还会涉及肖像权的问题。有网友指出,如果AI训练用的数据是从网上爬来的,要商用的话,必须保证它爬的不是禁止爬数据的网站。正常情况下,对人脸等敏感数据进行抓取需要授权和知情同意。

目前,各大AI作画平台对图像使用的规定都语焉不详。一些只是概括地规定不能制作色情内容,不能将图片用作有害用途,或者成为付费会员才能把成品图商用。DALL-E2和Stable Diffusion的协议里则提到,理论上所有成图的版权属于使用者,但如果它们和现存的其他图片相似度过高,AI工具不会为此负责,大体还是让使用者风险自负的意思。

“这一块依然是法律的灰色地带,”邢峰说,“以后可能需要一两场很大的官司来推动大家认知和变革。”

潮流难以阻挡

总结来说,AI作画被游戏开发者们视作一个相当有潜力的工具,但不管是出于现有的技术限制还是版权上的争议,它仍然处在探索阶段,尚无法大规模使用,并且短期内难以代替人工。

已经上架Steam的游戏《疯狂之源》(Source of Madness)是目前所知的唯一完全用AI生成怪物和场景,对这一技术进行密集运用的例子。但它本身是克苏鲁题材的,可以容纳各种奇异的怪物形象,最终视觉效果看起来也和通常意义上的商业游戏有一定距离。

《疯狂之源》的克苏鲁风格和AI生成的一些“不明觉厉”的形象相当搭配

不管怎么说,AI作画的潮流很难忽视,开发者们也不会拒绝能够降低成本、提高效率的新生产方式。许多独立游戏开发者乐于拥抱和研究这种变化。“毕竟你很难阻挡技术进步的脚步。”邢峰说。AI作画就像是现代建筑工人拥有的起重机,解放的是古代需要亲自扛石料的三千苦工,但工人本身无法替代。至于随之而来的其他摩擦和潜在的纠纷,可能是所有新事物在普及伊始都要面临的阵痛。